◆ 2021/04/28 ~ 2021/06/14

HuggingFace Transformers 4.6 : ノートブック : パイプラインの利用

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.6 をベースにドキュメントを幾つか翻訳しています。

今回はノートブックから「パイプラインの利用」です。パイプラインは次のような様々な下流タスクに渡る推論を行なうための高位の使いやすい API を提供します : センテンス分類 (センチメント分析)、トークン分類 (固有表現認識、品詞タギング)、質問応答、マスク Filling、要約、翻訳、特徴抽出 etc.

[詳細] (06/14/2021)

HuggingFace Transformers 4.6 : ノートブック : Getting Started Transformers

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.6 をベースにドキュメントを幾つか翻訳しています。

今回はノートブックから「Getting Started Transformers」です。transformers ライブラリは、Bert, Roberta, GPT2, XLNet 等のような Transformer アーキテクチャに基づくモデルを訓練し、利用して共有するためのオープンソース、コミュニティ・ベースのレポジトリです。

[詳細] (06/12/2021)

HuggingFace Transformers 4.6 : ノートブック : Getting Started トークナイザー

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.6 をベースにドキュメントを幾つか翻訳しています。

今回はノートブックから「Getting Started トークナイザー」です。transformers ライブラリとともに、@huggingface は一般的なマルチコアマシン上で数十 Gb/s でテキストを訓練、トークン化そしてデコードできる非常に高速なトークン化ライブラリを提供しています。

[詳細] (06/11/2021)

HuggingFace Transformers 4.6 : 上級ガイド : 事前訓練モデル

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.6 をベースにドキュメントを幾つか翻訳しています。

今回は上級ガイドから「事前訓練モデル」です。ここでは代表的な利用可能な事前訓練モデルが簡潔な説明とともにリストアップされています。

[詳細] (05/16/2021)

HuggingFace Transformers 4.6 : 概要

HuggingFace Transformers 4.6 がリリースされました。概要 (README) を再翻訳しておきます。BigBird-Pegasus, CLIP & LUKE の各モデルが追加されています。簡単な利用方法と利点、オンラインデモ、モデルのリスト等が説明されます。

Transformer アーキテクチャは NLP で中心的役割を果たしていますが、HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

[詳細] (05/15/2021)

HuggingFace Tokenizers 0.10 : メモリから訓練 (python)

HuggingFace Transformers のトークナイザーは HuggingFace Tokenizers に依存しています。切り捨て、パディングやモデルが必要な特殊トークンの追加など、前処理の総てを行ないます。Rust 実装のため非常に高速で Python と Node.js のバインディングも持ちます。

最新版の 0.10 ベースで幾つかドキュメントを翻訳しています。今回は「メモリから訓練 (python)」です。クイックツアー ではテキストファイルを使用してトークナイザーをどのように構築して訓練するかを見ましたが、実際には任意の Python Iterator を利用できます。このセクションではトークナイザーを訓練する幾つかの異なる方法を見ます。

[詳細] (06/01/2021)

HuggingFace Tokenizers 0.10 : コンポーネント (python)

HuggingFace Transformers のトークナイザーは HuggingFace Tokenizers に依存しています。切り捨て、パディングやモデルが必要な特殊トークンの追加など、前処理の総てを行ないます。Rust 実装のため非常に高速で Python と Node.js のバインディングも持ちます。

最新版の 0.10 ベースで幾つかドキュメントを翻訳しています。今回は「コンポーネント (python)」です。トークナイザーを構築するとき、その動作をカスタマイズするためにトークナイザーに様々なタイプのコンポーネントをアタッチできます。このドキュメントは提供されるコンポーネントの殆どをリストアップします。

[詳細] (06/05/2021)

HuggingFace Tokenizers 0.10 : トークン化パイプライン (python)

HuggingFace Transformers のトークナイザーは HuggingFace Tokenizers に依存しています。切り捨て、パディングやモデルが必要な特殊トークンの追加など、前処理の総てを行ないます。Rust 実装のため非常に高速で Python と Node.js のバインディングも持ちます。

最新版の 0.10 ベースで幾つかドキュメントを翻訳しています。今回は「トークン化パイプライン (python)」です。encode() を呼び出すとき、入力テキストは次のパイプラインを通過します :

- 正規化

- 事前トークン化

- モデル

- 後処理

これらのステップの各々の間に加えて、幾つかのトークン id をデコードすることを望むときに何が起きるか、そしてTokenizer ライブラリがニーズに応じて各ステップをどのようにカスタマイズするかを見ます。

[詳細] (05/31/2021)

HuggingFace Tokenizers 0.10 : Quicktour (python)

HuggingFace Transformers のトークナイザーは HuggingFace Tokenizers に依存しています。切り捨て、パディングやモデルが必要な特殊トークンの追加など、前処理の総てを行ないます。Rust 実装のため非常に高速で Python と Node.js のバインディングも持ちます。

最新版の 0.10 ベースで幾つかドキュメントを翻訳しています。今回は「Quicktour (python)」です。Tokenizers ライブラリの機能を素早く見てみます、このライブラリは使いやすく超高速な今日最も利用されているトークナイザーの実装を提供しています。スクラッチから構築することからクイックツアーを始めてそれをどのように訓練するかを見ます。

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

[詳細] (05/23/2021)

HuggingFace Tokenizers 0.10 : 概要 | Python バインディング概要

HuggingFace Transformers のトークナイザーは HuggingFace Tokenizers に依存しています。切り捨て、パディングやモデルが必要な特殊トークンの追加など、前処理の総てを行ないます。Rust 実装のため非常に高速で Python と Node.js のバインディングも持ちます。

最新版の 0.10 ベースで幾つかドキュメントを翻訳します。最初は概要と、Python バインディングの概要です。

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

[詳細] (05/20/2021)

TensorFlow 2.5.0 リリースノート

TensorFlow 2.5.0 ステーブル版がリリースされました。

いつものようにリリースノートの主要部分を翻訳しておきました。前バージョン (2.4.0) からおよそ 5ヶ月が経過しています。

注意すべき点は TensorFlow pip パッケージが CUDA11.2 と cuDNN 8.1.0 でビルドされていることです。

tf.data, tf.lite, tf.keras, tf.distribute モジュールが更新された他、Modular TensorFlow の実装として PluggableDevice がサポートされます。この結果、3rd パーティのデバイスは StreamExecutor C API / PluggableDevice I/F を通して接続可能になります。

[詳細] (05/14/2021)

HuggingFace Transformers 4.5 : 利用方法 : 多言語モデル

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.5 をベースにドキュメントを幾つか翻訳しています。

今回は「多言語モデル」です。利用可能な殆どのモデルは単一言語モデルですが、幾つかの多言語モデルが利用可能で単一言語モデルとは異なるメカニズムを持ちます。このドキュメントはそれらのモデルの使用方法を詳述します。多言語をサポートする 2 つのモデルは BERT と XLM です。

[詳細] (05/14/2021)

HuggingFace Transformers 4.5 : 利用方法 : トークナイザーの要点

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.5 をベースにドキュメントを幾つか翻訳しています。

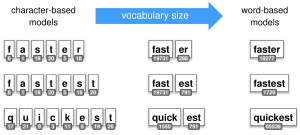

今回は「トークナイザーの要点」です。テキストのトークン化はそれを単語や部分単語に分割します、これらは検索テーブルを通して id に変換されます。単語や部分単語を id に変換することは簡単ですので、テキストを単語や部分単語を分割することにフォーカスします。

[詳細] (05/12/2021)

HuggingFace Transformers 4.5 : 利用方法 : 訓練と再調整

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.5 をベースにドキュメントを幾つか翻訳しています。

今回は「訓練と再調整」です。HuggingFace Transformers のモデル・クラスは PyTorch と TensorFlow 2 で互換であるように設計されシームレスに利用可能です。このチュートリアルでは、いずれのフレームワークでも利用可能な標準訓練ツールを使用してモデルをどのように再調整するか (or スクラッチから訓練するか) を示します。

[詳細] (05/11/2021)

HuggingFace Transformers 4.5 : 利用方法 : データの前処理

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.5 をベースにドキュメントを幾つか翻訳しています。

今回は「データを前処理する」です。このチュートリアルでは、 Hugging Transformers を使用して貴方のデータをどのように前処理するかを探求します。このための主要ツールは tokenizer と呼ぶものです。

[詳細] (05/11/2021)

HuggingFace Transformers 4.5 : 利用方法 : モデルの要点

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.5 をベースにドキュメントを幾つか翻訳しています。

今回は「モデルの概要」です。これは Hugging Transformers で利用可能なモデルの概要です。個々のモデルは以下のカテゴリーの一つに分類されます :

- 自己回帰モデル

- オートエンコーダ・モデル

- sequence-to-sequence モデル

- ProphetNet

- 検索ベースモデル

[詳細] (05/10/2021)

HuggingFace Transformers 4.5 : 利用方法 : タスクの要点

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.5 をベースにドキュメントを幾つか翻訳しています。

今回は Transformer の利用方法から「タスクの要点」で、ライブラリを利用するとき頻度の高いユースケースが示されます。利用可能なモデルはユースケースで素晴らしい多用途性を可能にします。質問応答、シークエンス分類、固有表現認識等々のようなタスクのための使用方法が紹介されます。

[詳細] (05/06/2021)

HuggingFace Transformers 4.5 : Gettiing Started : 用語集

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.5 をベースにドキュメントを幾つか翻訳しています。今回は Gettiing Started から「用語集」です。基本的な一般用語について簡単に説明された後、モデル入力について詳述されます。

[詳細] (05/06/2021)

HuggingFace Transformers 4.5 : Gettiing Started : 哲学

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.5 をベースにドキュメントを幾つか翻訳しています。今回は Gettiing Started から「哲学」というタイトルで、HuggingFace Transformers の幾つかの目標と主要なコンセプトについて説明されます。

[詳細] (05/05/2021)

HuggingFace Transformers 4.5 : Gettiing Started : クイック・ツアー

HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.5 をベースにドキュメントを幾つか翻訳しています。今回は Gettiing Started から「クイック・ツアー」です。Transformers ライブラリの特徴を概観します。ライブラリは、テキストのセンチメントを分析するような自然言語理解 (NLU) タスク、そしてプロンプトを新しいテキストで補完したり他の言語に翻訳するような自然言語生成 (NLG) のための事前訓練モデルをダウンロードできます。

最初にそれらの事前訓練モデルを推論で利用するためにパイプライン API をどのように容易に活用するかを見ます。それから、ライブラリがそれらのモデルへのアクセスをどのように与えて貴方のデータを前処理することを手助けするかを見ます。

[詳細] (04/28/2021)

AutoNLP 0.2 : 音声認識

AutoNLPは Hugging Face エコシステムとシームレスに統合された、最先端の NLP モデルを自動的に訓練・配備するための方法です。対応する NLP タスクは二値分類、マルチクラス分類、固有表現認識です。

0.2.6 をベースにドキュメントを幾つか翻訳しています。今回は音声認識です。AutoNLP は音声 (発話) モデルの再調整をサポートしますので、自動音声認識モデルを用意に訓練することができます。

[詳細] (05/05/2021)

AutoNLP 0.2 : 要約

AutoNLPは Hugging Face エコシステムとシームレスに統合された、最先端の NLP モデルを自動的に訓練・配備するための方法です。対応する NLP タスクは二値分類、マルチクラス分類、固有表現認識です。

0.2.6 をベースにドキュメントを幾つか翻訳しています。今回は要約です。要約タスクでは 2 つのシークエンスを持ち、より大きいシークエンスはより小さいシークエンスで表されます aka 要約されます。AutoNLP は貴方のデータ上で要約モデルを訓練することを非常に容易にします。

[詳細] (05/05/2021)

AutoNLP 0.2 : エンティティ抽出

AutoNLPは Hugging Face エコシステムとシームレスに統合された、最先端の NLP モデルを自動的に訓練・配備するための方法です。対応する NLP タスクは二値分類、マルチクラス分類、固有表現認識です。

0.2.6 をベースにドキュメントを幾つか翻訳しています。今回はエンティティ抽出です。エンティティ抽出 aka トークン分類は最もポピュラーなタスクの一つです。AutoNLP は貴方のデータ上でエンティティ抽出モデルを訓練することを非常に容易にします。

[詳細] (05/05/2021)

AutoNLP 0.2 : 多クラス分類

AutoNLPは Hugging Face エコシステムとシームレスに統合された、最先端の NLP モデルを自動的に訓練・配備するための方法です。対応する NLP タスクは二値分類、マルチクラス分類、固有表現認識です。

0.2.6 をベースにドキュメントを幾つか翻訳しています。今回は多クラス分類です。多クラス分類は NLP 問題を扱うときに遭遇するかもしれない最もポピュラーな教師あり分類問題です。AutoNLP は貴方のデータ上で多クラス分類モデルを訓練することを非常に容易にします。

[詳細] (05/05/2021)

AutoNLP 0.2 : 二値分類

AutoNLPは Hugging Face エコシステムとシームレスに統合された、最先端の NLP モデルを自動的に訓練・配備するための方法です。対応する NLP タスクは二値分類、マルチクラス分類、固有表現認識です。

0.2.6 をベースにドキュメントを幾つか翻訳しています。今回は二値分類です。二値分類は NLP 問題を扱うときに遭遇するかもしれない最もポピュラーな教師あり分類問題です。AutoNLP は貴方のデータ上で二値分類モデルを訓練することを非常に容易にします。

[詳細] (05/04/2021)

AutoNLP 0.2 : 概要

AutoNLPは Hugging Face エコシステムとシームレスに統合された、最先端の NLP モデルを自動的に訓練・配備するための方法です。対応する NLP タスクは二値分類、マルチクラス分類、固有表現認識です。

0.2.6 をベースにドキュメントを幾つか翻訳していきます。最初は概要 (README) ですが、内容はクイックスタートです。

[詳細] (05/04/2021)

HuggingFace Transformers 4.5 : 概要

Transformer アーキテクチャは NLP で中心的役割を果たしていますが、HuggingFace Transformers は最先端の自然言語処理を可能にする PyTorch と TensorFlow 2.0 のためのエコシステムです。両者はシームレスに統合され、一方で訓練してから推論のために他方でロードすることも可能です。モデルハブにより数千の事前訓練モデルが提供されています。

最近リリースされた 4.5 をベースにドキュメントを幾つか翻訳していきます。最初は概要 (README) です。簡単な利用方法と利点、オンラインデモ、モデルのリスト等が説明されます。

[詳細] (04/28/2021)

◆ 2021/01/04 ~ 2021/03/10

MediaPipe 0.8 : Colab : MediaPipe ポーズ

MediaPipe はライブ & ストリーミング・メディアのためのクロスプラットフォーム、カスタマイズ可能な ML ソリューションを提供します。Google によりオープンソースとして公開され、以下の特徴を持ちます : (1) End-to-End アクセラレーション (2) 一度ビルドすれば、どこでも配備可能 (3) Ready-to-use ソリューション (4) フリー & オープンソース。

0.8 をベースに幾つかドキュメントを翻訳します。今回は Colab から Python の MediaPipe ポーズ・ソリューションの使用サンプルです。ポーズ推定を遂行するために数十のキーポイントを検出します。

[詳細] (03/10/2021)

MediaPipe 0.8 : Colab : MediaPipe 全身用 (Holistic)

MediaPipe はライブ & ストリーミング・メディアのためのクロスプラットフォーム、カスタマイズ可能な ML ソリューションを提供します。Google によりオープンソースとして公開され、以下の特徴を持ちます : (1) End-to-End アクセラレーション (2) 一度ビルドすれば、どこでも配備可能 (3) Ready-to-use ソリューション (4) フリー & オープンソース。

0.8 をベースに幾つかドキュメントを翻訳します。今回は Colab から Python の MediaPipe 全身用 (Holistic) ソリューションの使用サンプルです。顔や手指に加えて、関節などの全身のキーポイントを検出します。

[詳細] (03/10/2021)

MediaPipe 0.8 : Colab : MediaPipe ハンド (Hands)

MediaPipe はライブ & ストリーミング・メディアのためのクロスプラットフォーム、カスタマイズ可能な ML ソリューションを提供します。Google によりオープンソースとして公開され、以下の特徴を持ちます : (1) End-to-End アクセラレーション (2) 一度ビルドすれば、どこでも配備可能 (3) Ready-to-use ソリューション (4) フリー & オープンソース。

0.8 をベースに幾つかドキュメントを翻訳します。今回は Colab から Python の MediaPipe ハンド (Hands) ソリューションの使用サンプルです。手指のキーポイントを検出します。

[詳細] (03/08/2021)

MediaPipe 0.8 : Colab : MediaPipe 顔メッシュ

MediaPipe はライブ & ストリーミング・メディアのためのクロスプラットフォーム、カスタマイズ可能な ML ソリューションを提供します。Google によりオープンソースとして公開され、以下の特徴を持ちます : (1) End-to-End アクセラレーション (2) 一度ビルドすれば、どこでも配備可能 (3) Ready-to-use ソリューション (4) フリー & オープンソース。

0.8 をベースに幾つかドキュメントを翻訳します。今回は Colab から Python の MediaPipe 顔メッシュ・ソリューションの使用サンプルです。

[詳細] (03/07/2021)

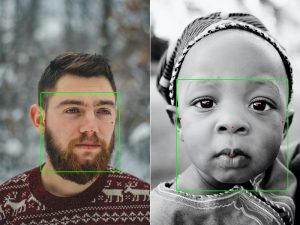

MediaPipe 0.8 : Colab : MediaPipe 顔検出

MediaPipe はライブ & ストリーミング・メディアのためのクロスプラットフォーム、カスタマイズ可能な ML ソリューションを提供します。Google によりオープンソースとして公開され、以下の特徴を持ちます : (1) End-to-End アクセラレーション (2) 一度ビルドすれば、どこでも配備可能 (3) Ready-to-use ソリューション (4) フリー & オープンソース。

0.8 をベースに幾つかドキュメントを翻訳します。今回は Colab から Python の MediaPipe 顔検出ソリューションの使用サンプルです。

[詳細] (03/06/2021)

MediaPipe 0.8 : 概要 (README)

MediaPipe はライブ & ストリーミング・メディアのためのクロスプラットフォーム、カスタマイズ可能な ML ソリューションを提供します。Google によりオープンソースとして公開され、以下の特徴を持ちます : (1) End-to-End アクセラレーション (2) 一度ビルドすれば、どこでも配備可能 (3) Ready-to-use ソリューション (4) フリー & オープンソース。

0.8 をベースに幾つかドキュメントを翻訳します。最初は概要 (README) です。

[詳細] (03/05/2021)

TensorFlow 2.4 : ガイド : モデルのセーブ – SavedModel 形式を使用する

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「モデルのセーブ」カテゴリーから、『SavedModel 形式を使用する』です。SavedModel は訓練パラメータと計算を含む、完全な TensorFlow プログラムを含みます。実行するためのオリジナルのモデル構築コードを必要としませんので、TFLite, TensorFlow.js, TensorFlow Serving や TensorFlow Hub で共有あるいは配備するために有用です。

[詳細] (01/30/2021)

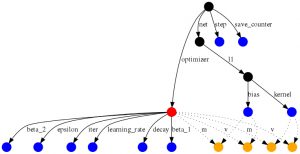

TensorFlow 2.4 : ガイド : モデルのセーブ – 訓練チェックポイント

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「モデルのセーブ」カテゴリーから、『訓練チェックポイント』です。「TensorFlow モデルをセーブする」は典型的には 2 つのことの一つを意味します : チェックポイント、または SavedModel です。チェックポイントはモデルにより使用される総てのパラメータの値を捕捉します。チェックポイントはモデルにより定義された計算のどのような記述も含みませんので、典型的にはソースコードが利用可能であるときにのみ有用です。

[詳細] (01/27/2021)

TensorFlow 2.4 : ガイド : Keras – Keras モデルをセーブしてロードする

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「Keras」カテゴリーから、『Keras モデルをセーブしてロードする』です。モデル全体をディスクにセーブするために使用できる 2 つの形式があります : TensorFlow SavedModel 形式、そしてより古い Keras H5 形式 です。推奨形式は SavedModel で、model.save() を使用するときそれはデフォルトです。

[詳細] (01/24/2021)

TensorFlow 2.4 : ガイド : Keras – 転移学習と再調整

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「Keras」カテゴリーから、『転移学習と再調整』です。転移学習は 1 つの問題上で学習された特徴を取り、そしてそれらを新しい類似の問題上で活用することから成ります。例えば、アライグマを識別するために学習したモデルからの特徴はタヌキを識別することを意図したモデルを始動するために有用かもしれません。転移学習はスクラッチから本格的なモデルを訓練するには貴方のデータセットが少な過ぎるデータを持つようなタスクのために通常は行なわれます。

[詳細] (01/22/2021)

TensorFlow 2.4 : ガイド : Keras – 貴方自身のコールバックを書く

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「Keras」カテゴリーから、『貴方自身のコールバックを書く』です。コールバックは 訓練、評価や推論の間の Keras モデルの動作をカスタマイズするためのパワフルなツールです。このガイドでは、Keras コールバックが何か、それは何ができるか、そして貴方自身のものをどのように構築できるかを学習します。

[詳細] (01/18/2021)

TensorFlow 2.4 : ガイド : Keras – Keras でマスキングとパディング

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「Keras」カテゴリーから、『Keras でマスキングとパディング』です。マスキングはシークエンス処理層に入力の一部の時間ステップが欠損しているために、データ処理時にスキップされるべきであることを伝える手段です。そしてパディングはマスキングの特殊な形式で、バッチの総てのシークエンスを標準的な長さにするためには、幾つかのシークエンスをパッドしたり切り詰めることです。

[詳細] (01/17/2021)

TensorFlow 2.4 : ガイド : Keras – 訓練ループをスクラッチから書く

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「Keras」カテゴリーから、『訓練ループをスクラッチから書く』です。Keras はデフォルトの訓練と評価ループ、fit() と evaluate() を提供します。訓練 & 評価に渡り非常に低位な制御を望む場合、貴方自身の訓練 & 評価ループをスクラッチから書くべきです。このガイドはこれについて説明されます。

[詳細] (01/16/2021)

TensorFlow 2.4 : ガイド : Keras – Model.fit で起きることをカスタマイズする

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「Keras」カテゴリーから、『Model.fit で起きることをカスタマイズする』です。教師あり学習を行なっているとき fit() を使用できて総てがスムースに動作します。しかしカスタム訓練アルゴリズムを必要としながら fit() の便利な特徴から依然として恩恵を受けることを望む場合にはどうでしょう?fit() が行なうことをカスタマイズする必要があるとき、Model クラスの訓練ステップ関数を override するべきです。

[詳細] (01/15/2021)

TensorFlow 2.4 : ガイド : Keras – 前処理層で作業する

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「Keras」カテゴリーから、『前処理層で作業する』です。Keras 前処理層 API は開発者に Keras-ネイティブな入力処理パイプラインを構築することを可能にします。これらの入力処理パイプラインは Keras モデルと直接結び付けられ、非-Keras ワークフローにおける独立した前処理コードとして利用できます。Keras 前処理層で真に end-to-end なモデルを構築してエクスポートできます。

[詳細] (01/14/2021)

TensorFlow 2.4 : ガイド : Keras – Keras でリカレント・ニューラルネットワーク (RNN)

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「Keras」カテゴリーから、『Keras でリカレント・ニューラルネットワーク (RNN)』です。リカレント・ニューラルネットワーク (RNN) は、時系列や自然言語のようなシークエンス・データをモデル化するためのパワフルなニューラルネットワークのクラスです。このガイドでは組込みの keras.layers.RNN, LSTM, GRU 層の使い方を中心に解説されます。

[詳細] (01/13/2021)

TensorFlow 2.4 : ガイド : Keras – サブクラス化で新しい層とモデルを作成する

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「Keras」カテゴリーから、『サブクラス化で新しい層とモデルを作成する』です。Keras の中心的な抽象の一つは Layer クラスです。層は状態と入力から出力への変換をカプセル化します。一般に、内側の計算ブロックを定義するために Layer クラスを使用し、外側のモデル (貴方が訓練するオブジェクト) を定義するために Model クラスを使用します。

[詳細] (01/12/2021)

TensorFlow 2.4 : ガイド : Keras – 組込みメソッドで訓練と評価

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「Keras」カテゴリーから、『組込みメソッドで訓練と評価』です。このガイドは model.fit(), model.evaluate(), model.predict() のような訓練と検証のための組込み API を利用する、訓練と評価そして予測 (推論) モデルをカバーします。

[詳細] (01/11/2021)

TensorFlow 2.4 : ガイド : Keras – Functional API

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「Keras」カテゴリーから、『Functional API』です。Keras Functional API は tf.keras.Sequential API よりも柔軟なモデルを作成する方法です。functional API は非線形トポロジー、共有層、そしてマルチ入力と出力を持つモデルさえ扱うことができます。

[詳細] (01/10/2021)

TensorFlow 2.4 : ガイド : Keras – シーケンシャル・モデル

TensorFlow 2.4 のドキュメントでは幾つかガイドが追加されたり改訂もされていますので、再翻訳しています。

今回はガイド「Keras」カテゴリーから、『シーケンシャル・モデル』です。シーケンシャル・モデルは層の平易なスタックのために適切です、そこでは各層は正確に 1 つの入力 tensor と 1 つの出力 tensor を持ちます。

[詳細] (01/09/2021)

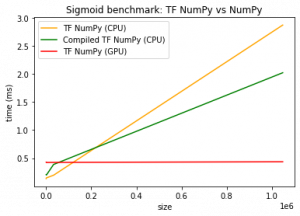

TensorFlow 2.4 : ガイド : 基本 – TensorFlow 上の NumPy API

TensorFlow 2.4 のドキュメントで幾つかガイドが追加されましたので、再翻訳しています。

今回はガイド「TensorFlow 基本」カテゴリーから、『TensorFlow 上の NumPy API』です。TensorFlow は tf.experimental.numpy として利用可能な NumPy API のサブセットを実装しています。これは TensorFlow によりアクセラレートされた NumPy コードを実行することを可能にする一方で、TensorFlow の API の総てへのアクセスも可能にします。

[詳細] (01/08/2021)

TensorFlow 2.4 : ガイド : 基本 – Ragged Tensor (不規則なテンソル) パート II

TensorFlow 2.4 のドキュメントで幾つかガイドが追加されましたので、再翻訳しています。

今回はガイド「TensorFlow 基本」カテゴリーから、『不規則な (Ragged) Tensor パート II』です。このガイドでは、Ragged Tensor (不規則なテンソル) を扱います。ragged tensor は (Python の) ネストされた可変長リストの TensorFlow における等値なものです。

[詳細] (01/05/2021)

TensorFlow 2.4 : ガイド : 基本 – Ragged Tensor (不規則なテンソル) パート I

TensorFlow 2.4 のドキュメントで幾つかガイドが追加されましたので、再翻訳しています。

今回はガイド「TensorFlow 基本」カテゴリーから、『不規則な (Ragged) Tensor パート I』です。このガイドでは、Ragged Tensor (不規則なテンソル) を扱います。ragged tensor は (Python の) ネストされた可変長リストの TensorFlow における等値なものです。

[詳細] (01/04/2021)

◆ お問合せ

本件に関するお問い合わせ先は下記までお願いいたします。

| 株式会社クラスキャット |

| セールス・マーケティング本部 セールス・インフォメーション |

| E-Mail:sales-info@classcat.com |

| WebSite : https://www.classcat.com/ |

| Facebook : https://www.facebook.com/ClassCatJP/ |

※ TensorFlow, the TensorFlow logo and any related marks are trademarks of Google Inc.

※ その他、記載されている会社名・製品名は各社の登録商標または商標です。